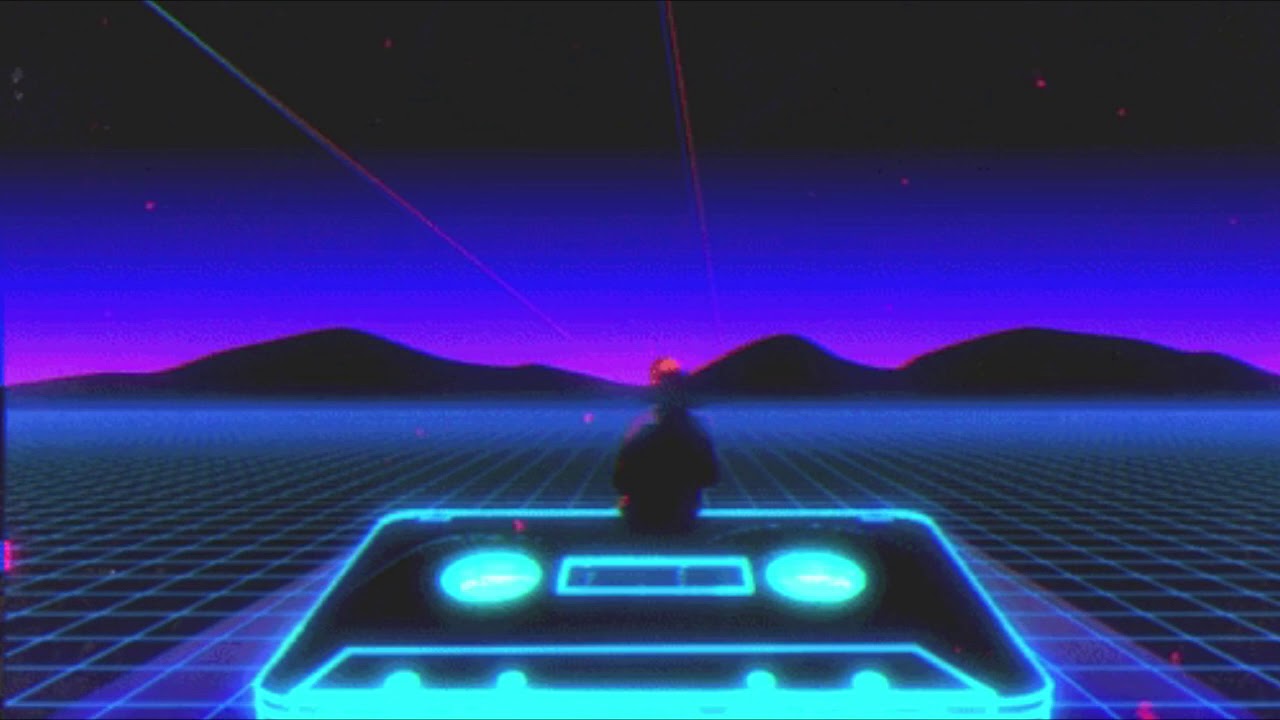

「复古未来」SYNTHWAVE合成器浪潮

BACK TO THE FUTURE : 重回 80s 霓虹情结与赛博幻象

“我所见过的事物,你们人类绝对无法置信。我目睹太空飞船在猎户星座的端沿被击中,燃起熊熊火光。我看着C 射线在唐怀瑟之门附近的幽暗中闪耀。然而这些时刻终将湮没在时间里,就像泪水消失在雨中。” –《银翼杀手》

上世纪 60 年代,NASA 的两位科学家曼弗雷德・克林斯和内森・克兰取了 “控制论”(cybernetics)与 “有机体”(organism)两词的词首造出 “赛博格”(Cyborg)一词,用来描述通过医学、生物学、仿生学等技术对有机体进行控制的人和人造物组成的统一功能体。